Ollama Hosting – blitzschnell auf deutschen GPU-Servern

Nutze die volle GPU-Power in deutschen Rechenzentren und betreibe mit uns eine Vielzahl von Open-Source KI Modellen – 100 % DSGVO-konform, ohne Infrastruktur-Stress.

Warum Ollama bei ennoia?

Open-Source KI mit deutscher Sicherheit

Modernste GPU-Infrastruktur trifft auf höchste Datenschutzstandards. Wir betreiben Ollama und Open-Source KI-Modelle auf deutschen Servern – damit Du die volle Kontrolle behältst.

Von Llama bis Mistral, von Chat-Bots bis RAG-Systemen – wir übernehmen die komplette Infrastruktur, damit Du Dich auf Dein Business konzentrieren kannst.

Datenschutz made in Germany

Hosting ausschließlich in zertifizierten deutschen Rechenzentren – keine Daten verlassen die EU.

GPU-Power on demand

Modernste NVIDIA-GPUs sorgen für niedrige Latenz und skalieren automatisch mit deinem Bedarf.

Offene Modelle, volle Flexibilität

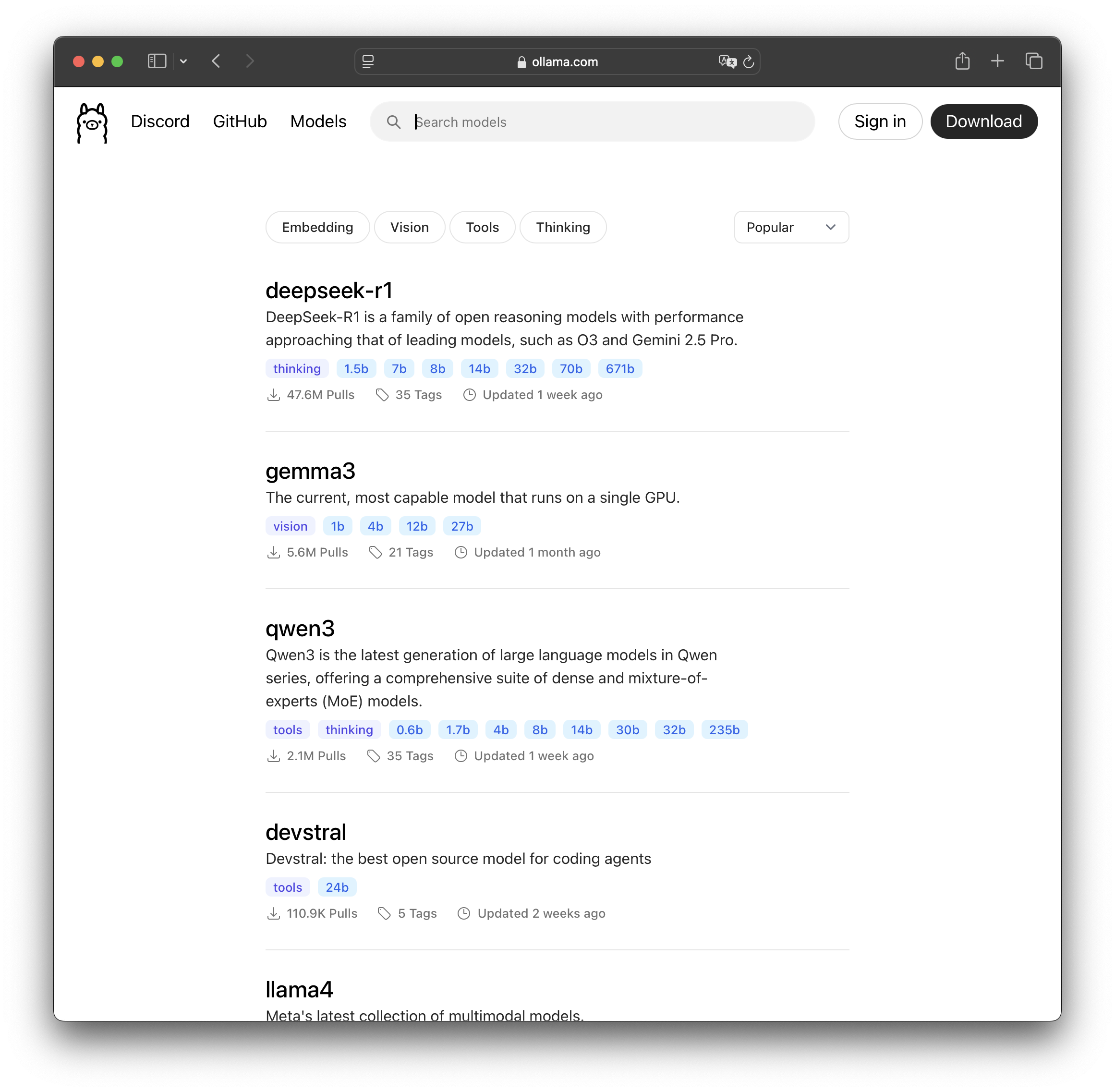

Llama 3, Mistral, Mixtral, Phi-3 & Co. – wir betreiben jedes Open-Source-Modell, das zu deinem Use Case passt.

Managed Service

Deployment, Updates, Monitoring und Betrieb liegen bei uns – dein Team konzentriert sich auf das Produkt.

Was wir für Dich übernehmen

Vollständiger Ollama Managed Service

Von der ersten Instanz bis zum Production-Betrieb – wir kümmern uns um alle technischen Aspekte deiner Ollama-Infrastruktur.

-

Bereitstellung von Ollama-Instanzen

- Docker-basierte Deployments.

-

Feintuning & Quantisierung

- Optimierung deiner gewählten Modelle für maximale Performance und minimalen Ressourcenverbrauch.

-

Sichere API-Endpoints

- Verschlüsselte Endpunkte für Chat, Completion & Embedding mit Authentifizierung und Rate-Limiting.

-

Optional: RAG mit Vektor-DB

- Retrieval-Augmented Generation mit hochperformanten Vektor-Datenbanken für kontextbezogene Antworten.

Typische Use Cases

Wo Ollama den Unterschied macht

Von internen Chat-Assistenten bis hin zu F&E-Prototypen – diese Anwendungsfälle profitieren besonders von deutschen GPU-Servern und Open-Source Modellen.

Interne Chat-Assistenten

Sicheres Firmen-Know-how statt Public Cloud – deine Mitarbeiter bekommen KI-Support ohne Datenschutz-Risiken.

Dokumenten-Analyse & Zusammenfassung

Große Datenmengen, kurze Antwortzeiten – perfekt für Rechts-, Finanz- oder Compliance-Teams.

KI-Agenten & Automatisierung

Ollama als Herzstück deiner Workflows – von E-Mail-Klassifizierung bis automatischer Kundenbetreuung.

F&E-Prototypen

Schnell testen, ohne eigene Infrastruktur aufzubauen – ideal für Innovation Teams und Startups.

So läuft's ab

Von der Idee zur produktiven Ollama-Instanz

Einfacher Prozess, schnelle Umsetzung – in wenigen Tagen hast du deine eigene Ollama-Infrastruktur am Laufen.

Kennenlernen

30 min Call – wir verstehen deinen Bedarf und besprechen die passenden Modelle und GPU-Anforderungen.

Individuelles Setup

Auswahl der Modelle & GPU-Größen, Konfiguration der Sicherheitsrichtlinien und API-Endpoints.

Go-Live

Deine Instanz ist nach wenigen Tagen produktiv.

Kontakt aufnehmen

Wir freuen uns immer auf Gespräche mit Dir.

Und so

kommst Du mit uns in Kontakt.